Tiempo de lectura aprox: 2 minutos, 57 segundos

La empresa que creó AlphaZero desarrolla un programa que logra un nivel de casi 2900 puntos Elo en partidas rápidas sin buscar en el árbol de variantes

DeepMind es una de las empresas más importantes del siglo XXI. Por suerte, en sus oficinas todavía se hacen algunas incursiones ajedrecísticas. En una de ellas han creado un programa que juega a un nivel escandaloso, casi 2900 puntos de Elo en Lichess, sin profundizar ni una sola jugada, «sin pensar», sin explorar el árbol de variantes ni hacer todo lo que recomiendan los clásicos. Como decíamos de David Bronstein con motivo de su centenario, es la demostración de que «se puede jugar de otra manera».

Para poner en contexto lo que hace este nuevo ingenio, los investigadores citan una famosa frase de Capablanca. Un día le preguntaron al cubano cuántas jugadas era capaz de calcular con antelación y se le ocurrió una respuesta brillante: «Yo solo veo un movimiento, pero siempre es el correcto». Hasta que llegó AlphaZero, las máquinas han recurrido al método contrario, calcular todo lo que pueden, con mayor o menor refinamiento para ahorrar esfuerzos, y utilizar esa fuerza bruta de cálculo para elegir la mejor jugada. El nuevo monstruo de DeepMind, que ahora pertenece a Google, lleva al extremo el espíritu de Capablanca, pero sin chulerías.

DeepMind fue creada por Demis Hassabis, un genio al que el ajedrez se le quedó pequeño. Antes de lanzarse en busca de metas más altas nos regaló AlphaGo y AlphaZero, con los que revolucionó la historia de la inteligencia artificial en los tableros, siempre con el aprendizaje profundo como bandera.

GM sin búsquedas

El documento científico, titulado «Nivel de gran maestro sin búsquedas», está firmado por varios autores, entre los que destaca el español Jordi Grau-Moya. Los otros son Anian Ruoss, Grégoire Delétang, Sourabh Medapati, Li Kevin Wenliang, Elliot Catt, John Reid y Tim Genewein. En el texto explican que el modelo más evolucionado de su criatura (Transformer) ha alcanzado 2895 puntos Elo jugando en Lichess contra humanos. Los pellejudos pueden ser un rival fácil cuando se les presiona y la máquina no es tan eficaz cuando se enfrenta a sus semejantes (su nivel cae a 2300), pero no hay que olvidar que juega «sin pensar», y que sus errores son más explotables por las almas de metal.

Además de rendir a ese nivel tan alto, el nuevo bicho resuelve con éxito la mayoría de problemas «sin ningún ajuste específico del dominio o algoritmos de búsqueda explícitos». El ‘papel’ recuerda los éxitos de IBM con Deep Blue, cuando derrotó a Kasparov en 1997. Desde entonces, todas las máquinas, salvo AlphaZero, imitaron sus métodos, que ya existían desde mucho antes. Stockfish es la mejor de las actuales, pero Leela Chess Zero, hija de código abierto de DedepMind, es la segunda más potente con su particular aproximación al juego.

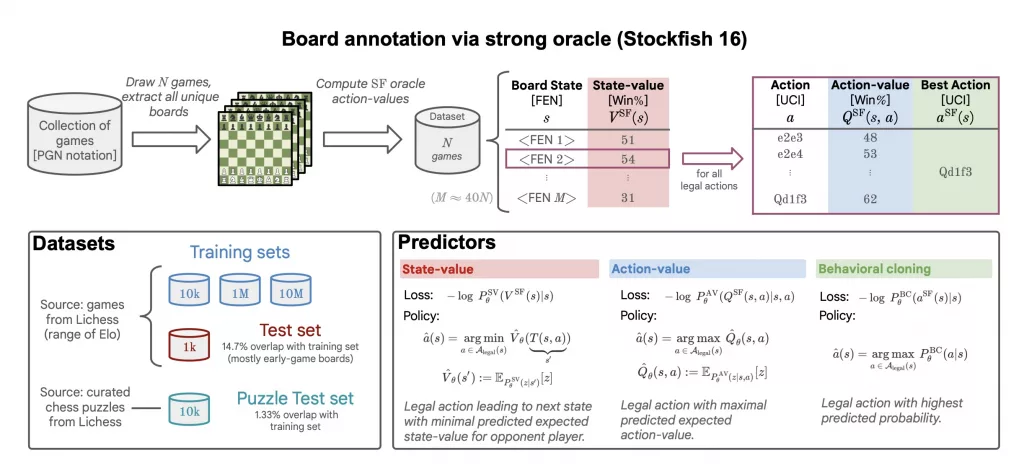

Con los últimos avances de la Inteligencia Artificial sobre la mesa, los investigadores se plantearon una pregunta: ¿Es posible utilizar el aprendizaje supervisado para obtener una máquina que juegue bien al ajedrez sin buscar jugadas entre las variantes? Para evaluar sus resultados, utilizaron a Stockfish como oráculo y juez último de lo que son las buenas y las malas jugadas, que es lo que hacen a diario los grandes maestros.

Así, y después de descargarse diez millones de partidas en Lichess para alimentar a la bestia, los investigadores comprobaron que esta era capaz de predecir las jugadas idóneas mejor que los ChatGPT de turno (versiones 3.5 y 4), lo que tampoco es un logro exagerado porque juegan de pena. Mucho más mérito tuvo superar al mismísimo AlphaZero, algo que Reuben Fine y Sigmund Freud considerarían turbio.

El resultado fue un buen discípulo de Stockfish 16, por su capacidad para predecir la mejor jugada casi como por intuición, por arte de magia. Además de jugar blitz al nivel de 2895 puntos Elo, resuelve problemas con la fuerza de un 2800. «Hasta donde sabemos, este es actualmente el motor de ajedrez más fuerte sin búsqueda explícita», aseguran sus padres con orgullo.

Mejor rendimiento en partidas que en problemas

Los investigadores también explican por qué a su programa se le dan mejor las partidas que los puzles: «Hacemos hincapié en que resolver rompecabezas requiere anticipar una secuencia de movimientos correcta y nuestra máquina no puede planificar explícitamente con anticipación». Pese a todo, rinde mejor que los otros programas probados en este campo, con la excepción de Stockfish. Pero dado que no piensa en el sentido tradicional del término, cuando se reducen los tiempos para resolver cada ejercicio y solo les permiten 0,05 segundos (convengamos en que no es mucho tiempo), los resultados son casi idénticos a los de Stockfish.

Por supuesto, esta forma de jugar tampoco es la correcta. En el ajedrez de verdad siempre hace falta calcular las jugadas, por muy grande que sea la superioridad estratégica o la intuición capablanquiana. Por eso, al Transformer se le escapaban partidas que tenía completamente ganadas o incluso es incapaz de predecir que le pueden hacer unas simples tablas por repetición. Con todo, el espíritu del trabajo, demostrar que se puede jugar a lo Capablanca, parece demostrado. El plan es llevarlo a otros terrenos de la vida, más prácticos pero menos bonitos que el ajedrez.

Antes de marcharte, te quiero pedir un favor

Comment